Open WebUI 安装部署及使用方法 - 本地网页版 AI 系统

随着人工智能技术的飞速发展,大型语言模型(LLM)已经成为我们生活中不可或缺的一部分。然而,许多用户希望在本地运行这些模型,以保护数据隐私或实现更灵活的定制化需求。这时,Open WebUI 就成为了一个理想的选择。本文将为您介绍 Open WebUI 是什么,它的特性,以及如何进行基本使用。

什么是 Open WebUI?

Open WebUI 是一个开源的、自托管的 Web 用户界面,专为与大型语言模型交互而设计。它支持多种 LLM 运行器,包括 Ollama 和与 OpenAI 兼容的 API,旨在提供一个功能丰富、用户友好且完全离线运行的平台。无论是开发者、研究人员还是普通用户,Open WebUI 都能帮助他们轻松管理和使用本地或远程的 AI 模型。

Open WebUI 的设计灵感来源于 ChatGPT,界面直观且响应迅速,同时支持桌面和移动设备。它不仅适用于个人使用,还可以通过权限管理和插件扩展,满足团队协作或更复杂的需求。当前,Open WebUI 在 GitHub 上已经收获了广泛关注,成为本地化部署 AI 模型的热门选择。

功能特性

1. 直观的用户界面

Open WebUI 的界面设计简洁明了,类似于 ChatGPT,用户可以轻松上手。通过文本输入框和聊天窗口,您可以与模型进行自然对话。

2. 完全离线运行

对于注重隐私的用户来说,Open WebUI 的离线功能是一个亮点。它可以在没有互联网连接的情况下工作,确保数据安全。

3. 多模型支持

Open WebUI 支持多种 LLM 运行器,例如 Ollama、LM Studio、GroqCloud 等。您可以根据需求切换不同的模型,甚至同时与多个模型对话。

4. 本地 RAG 集成

检索增强生成(RAG)功能允许用户将本地文档集成到聊天中,提升回答的准确性和针对性。

5. 丰富的扩展性

通过插件框架(Pipelines),用户可以添加自定义功能,例如实时翻译、网页搜索或 Python 函数调用。

6. 跨设备兼容

Open WebUI 支持桌面、笔记本和移动设备,甚至可以通过渐进式 Web 应用(PWA)在手机上离线使用。

如何安装部署 Open WebUI?

一、使用 Python pip 安装

Open WebUI 可以使用Python 包中的 pip 工具进行安装。在继续之前,请确保您使用的是 Python 3.11 以避免兼容性问题。

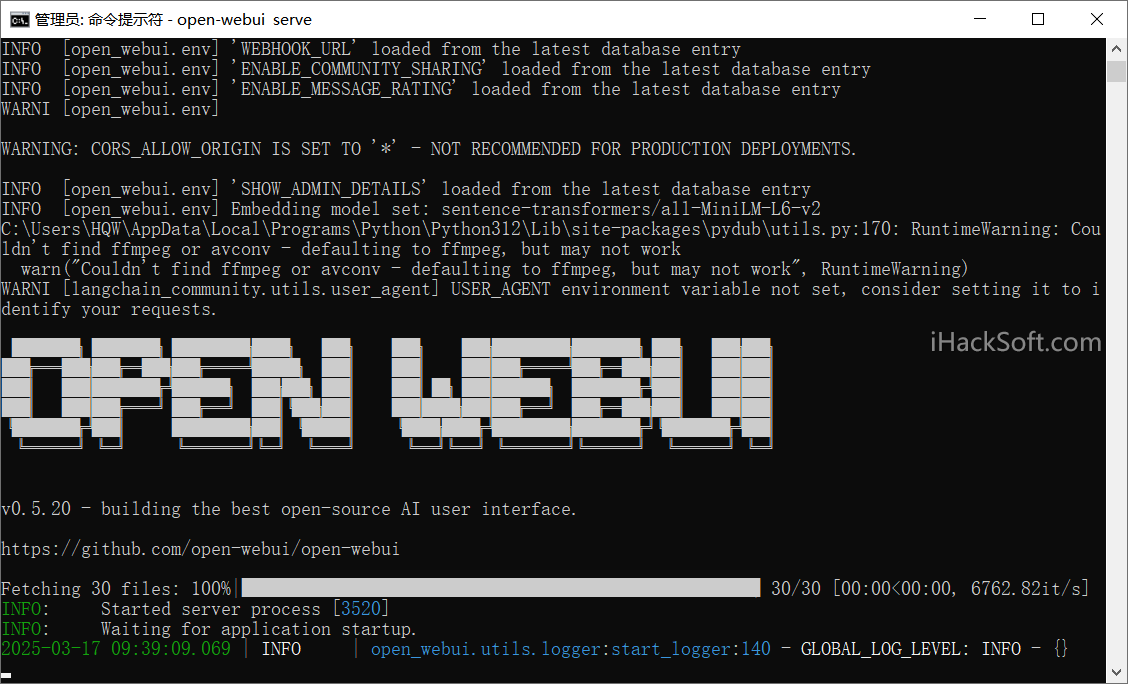

安装 Open WebUI: 打开您的终端并运行以下命令来安装:

pip install open-webui

运行 Open WebUI: 安装后,您可以通过执行以下命令启动:

open-webui serve

这将启动 Open WebUI 服务器,可通过 http://localhost:8080 访问它。

二、通过 docker 下载安装

如果你的计算机上已经安装了 Ollama,请使用以下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

如果 Ollama 在另一台服务器上,使用以下命令:

要连接到另一台服务器上的 Ollama,请将 OLLAMA_BASE_URL 更改为服务器的 URL:

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

要运行支持 Nvidia GPU 的 Open WebUI,使用以下命令:

docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda

如果只使用 OpenAI API,使用以下命令:

docker run -d -p 3000:8080 -e OPENAI_API_KEY=your_secret_key -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

同时安装 Ollama 和 Open WebUI

此安装方法使用将 Open WebUI 与 Ollama 捆绑在一起的单个容器映像,从而允许通过单个命令进行简化设置。根据您的硬件设置选择适当的命令:

借助 GPU 支持:通过运行以下命令来利用 GPU 资源:

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

仅适用于 CPU:如果您不使用 GPU,请改用以下命令:

docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

这两个命令都实现了 Open WebUI 和 Ollama 的内置、免安装设置,确保您能够快速启动和运行。安装后,您可以通过 http://localhost:3000 访问 Open WebUI。

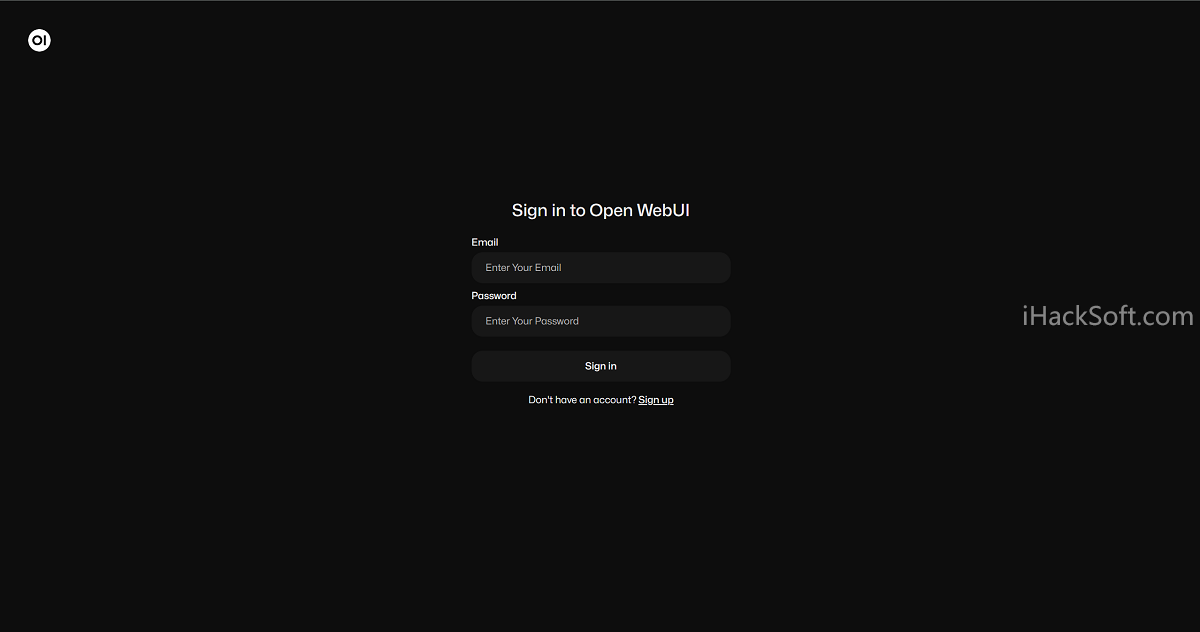

三、基本使用方法

输入用户名和密码注册并登录。登录后,您可以进入管理员设置(右上角“设置” > “管理员设置”),配置模型连接地址或其他参数。

在聊天界面顶部,点击模型选择下拉菜单。如果本地已有模型(例如通过 Ollama 下载的模型),它们会自动显示。若需添加新模型,可在“模型管理”中手动输入模型参数(如 OpenAI 兼容 API 的 URL 和密钥)。

成功配置之后,你可以在文本输入框中输入问题或指令,按回车键发送。模型会实时生成回复,显示在聊天窗口中。并且支持 Markdown 格式,您可以输入代码或公式,界面会自动高亮显示。

综上,Open WebUI 是一个功能强大且灵活的工具,它将复杂的 AI 模型交互简化成了一个直观的 Web 界面。无论您是想在本地运行开源模型,还是希望连接远程 API,Open WebUI 都能满足需求。通过简单的安装和基本操作,您就可以拥有一个属于自己的“私人 ChatGPT”。